EuroLLM vient de prouver qu’on pouvait faire tourner un modèle à 9 milliards de paramètres dans un peu moins de 6 GB de RAM sur un simple laptop.

Bien sûr, il est encore loin des gros modèles proprio comme GPT-5 mais c’est le enfin le premier LLM européen que VOUS pouvez faire tourner en local. C’est respectueux de votre vie privée, des droits d’auteurs et c’est gratuit !

Vous installez l’extension sur Chrome, Firefox, Brave ou Edge, vous installez Ollama ou vous utilisez WebLLM directement dans le navigateur. Ensuite, vous téléchargez un modèle (DeepSeek, Qwen, Llama, ce que vous voulez) et c’est tout. Vous avez maintenant votre IA personnelle qui tourne sur votre laptop sans rien demander à personne, et accessible directement sur votre navigateur.

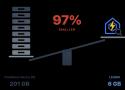

60 millions de documents, c’est ce que LEANN peut indexer sur votre petit laptop sans faire exploser votre SSD. en compressant tout pour que ça tienne sur un portable. cette approche réduit l’espace de stockage de 97% par rapport aux solutions classiques comme Pinecone ou Qdrant. ça maintient 90% de précision avec des temps de réponse sous les 2 secondes.

Et si vous aviez votre propre IA, 100 % locale, sans internet et privée ? Ce guide vous montre comment faire tourner un LLM sur votre PC